Ein Large Language Model (LLM) ist im Wesentlichen ein maschinelles Lernalgorithmus, der natürliche Sprache verarbeitet und versteht (also das, was Sie und ich als „menschliche Sprache“ bezeichnen würden). Es handelt sich um einen sogenannten Foundation Model (ein allgemeines Sprachmodell), das auf enormen Datenmengen trainiert wurde, um eine unendliche Anzahl von Aufgaben zu erfüllen, darunter Textgenerierung, maschinelle Übersetzung, Zusammenfassungen und sogar maschinelles Programmieren.

LLMs verwenden Deep-Learning-Methoden, um die komplexen sprachlichen Beziehungen zwischen Semantik und Syntax einer Sprache korrekt zu interpretieren und zu analysieren, um bestimmte Aktionen auszuführen.

Large Language Models und künstliche Intelligenz

LLMs stellen einen bedeutenden Durchbruch in der künstlichen Intelligenz und der Verarbeitung natürlicher Sprache (NLP) dar. Sie sind der Grund dafür, dass wir Schnittstellen wie ChatGPT und andere generative KI-Modelle nutzen können, ohne Programmierkenntnisse zu benötigen. Denken Sie an das letzte Mal, als Sie ein KI-Tool verwendet haben: Haben Sie so geschrieben, wie Sie es auch in einem Gespräch mit einem Menschen tun würden?

Kurz gesagt, LLMs sind darauf ausgelegt, Texte so zu verstehen und zu generieren, wie es ein echter Mensch tun würde. Zudem lernen sie ständig dazu und verarbeiten regelmäßig enorme Datenmengen, um aus dem Kontext Schlüsse zu ziehen, Texte zusammenzufassen und Fragen zu beantworten.

In den fortschrittlichsten generativen KI-Modellen werden LLMs darauf trainiert, bei der Erstellung kreativer Inhalte oder wissenschaftlicher Arbeiten zu unterstützen. (Es muss beachtet werden, dass die Genauigkeit und Qualität dieser erstellten Inhalte noch nicht ganz den Standards entspricht, aber allein die Tatsache, dass KI dies jetzt tun kann, ist beeindruckend).

Dennoch sind die Möglichkeiten, die ein LLM bietet, verblüffend. Es ist nicht weit hergeholt, sich unzählige Verbesserungen in verschiedenen Bereichen vorzustellen, von Chatbots über virtuelle Assistenten bis hin zur Sprachübersetzung. Selbst im IT-Bereich, der sich paradoxerweise gegen generative KI sträubt, die beispielsweise bei der Codegenerierung oder der Ausbildung in Cybersicherheit helfen soll, sind LLMs in der Lage, die Art und Weise, wie wir mit Technologie interagieren und auf Informationen zugreifen, neu zu gestalten und zu beeinflussen.

Tatsächlich hat die neueste McKinsey-Studie ergeben, dass 65 % der Unternehmen generative KI regelmäßig in mindestens einer Geschäftsfunktion einsetzen. Diese Zahl wird in den kommenden Jahren voraussichtlich noch steigen.

Wie große Sprachmodelle funktionieren

LLMs nutzen Deep-Learning-Techniken und Textdaten. Diese Modelle bestehen in der Regel aus mehreren Schichten neuronaler Netze, deren Parameter während des Trainings weiter verbessert und erweitert werden können.

Während des Trainings wird dem großen Sprachmodell beigebracht, wie es das nächste Wort in einem Satz auf der Grundlage des Kontexts vorhersagen kann. Zu diesem Zweck werden mathematische Modelle angewandt, um die Wahrscheinlichkeit des Wiederauftretens von tokenisierten Wörtern (kleinere Zeichenfolgen) zu berechnen. Die Token werden dann in numerische Repräsentationen des Kontexts übersetzt.

Dies ist der erste Teil. LLMs werden dann rigoros mit riesigen Textmengen (buchstäblich Milliarden und Abermilliarden von Seiten) trainiert, damit sie die Grammatik, einschließlich der Beziehung zwischen Semantik und Syntax, lernen. Dies stellt sicher, dass der numerische Kontext korrekt ist oder ob der generierte Satz „Sinn ergibt“.

Einmal trainiert, können große Sprachmodelle Texte generieren, indem sie das nächste Wort basierend auf den Eingaben vorhersagen und dann Muster dafür lernen, wie Sätze gebildet werden.

Wie bei jedem prädiktiven und generativen Tools ist kontinuierliches Feintuning erforderlich, bei dem Methoden wie Reinforcement Learning mit menschlichem Feedback (RLHF) eingesetzt werden. Beim Reinforcement Learning mit menschlichem Feedback (RLHF) lernen LLMs mehr über die „menschlichen“ Aspekte von Sprache und Kommunikation. Es ist zum Beispiel schwierig, einen Algorithmus zu entwickeln, der definiert, was „lustig“ ist. Mathematisch gesehen ist das fast unmöglich, aber menschliches Feedback kann Witze bewerten, was wiederum dem LLM das Konzept des Humors vermittelt. So hilft das menschliche Feedback den LLMs, durch Versuch und Irrtum ganzheitlich zu lernen – wobei das Modell durch starke Anreize hoch motiviert ist, erfolgreich zu sein.

LLMs und ihre Verwendung in der Endpunktverwaltung

Vielleicht denken Sie, dass große Sprachmodelle und Endpoint-Management völlig unterschiedliche Konzepte sind. Als MSP-Führungskraft fragen Sie sich vielleicht, warum NinjaOne überhaupt über LLMs spricht.

LLMs werden jedoch zunehmend mit modernen Unternehmen verflochten. Ihre Fähigkeit, menschenähnlichen Text zu verarbeiten und zu generieren, bietet ein erhebliches Potenzial zur Verbesserung der Endpunktverwaltung.

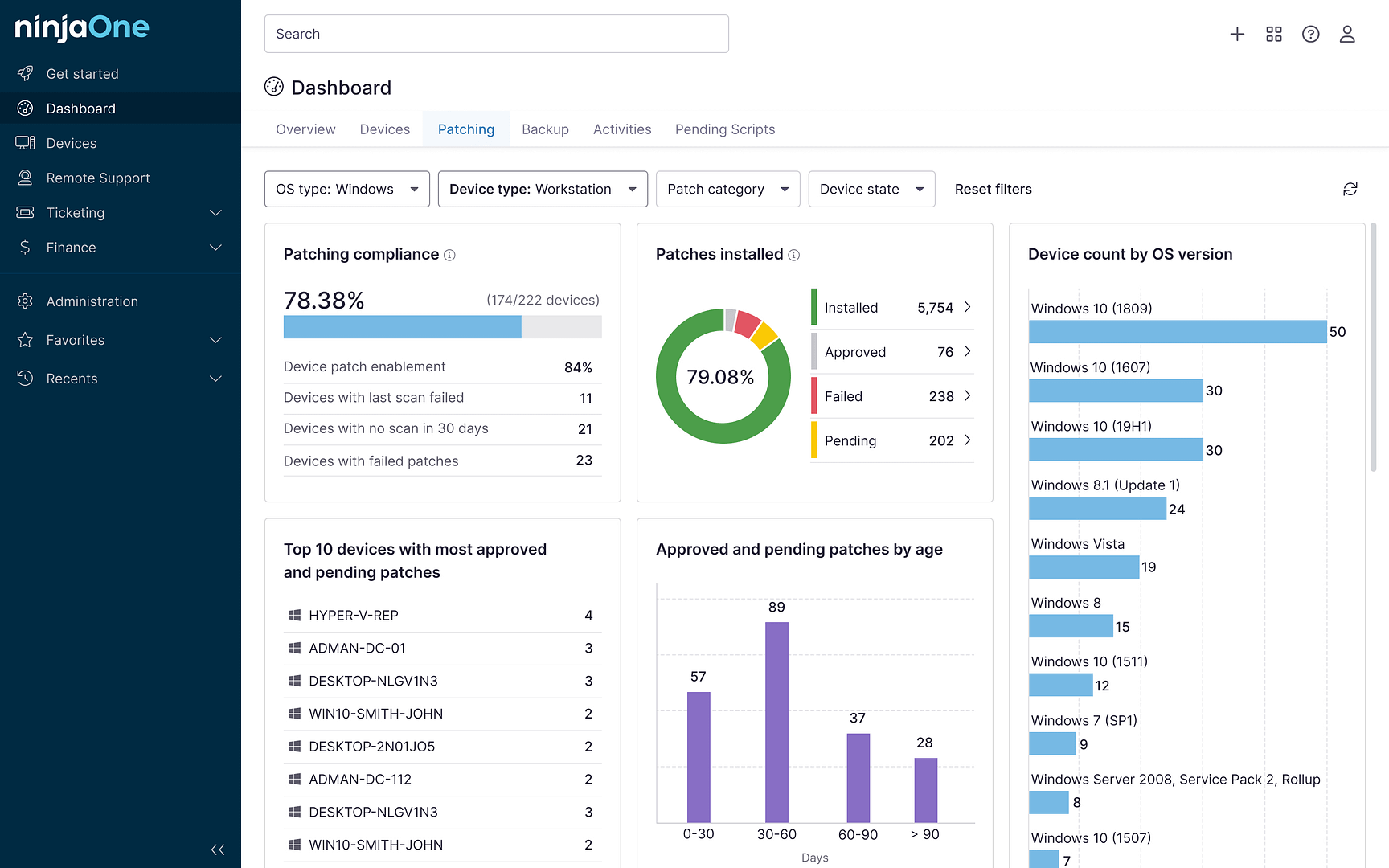

Einerseits können LLMs Routineaufgaben wie Patch-Management, Software-Updates und die Reaktion auf Zwischenfälle automatisieren. Durch die Analyse großer Datenmengen von Endpunkten können LLMs Muster erkennen, Probleme vorhersagen und optimale Lösungen vorschlagen. Dadurch kann sich Ihr IT-Team auf strategisch wichtigere Projekte konzentrieren.

Umgekehrt liefert die Endpunktverwaltung wichtige Daten, damit LLMs effektiv arbeiten können. Umfassende Endpunktdaten, einschließlich Softwareinventar und Hardwarespezifikationen, ermöglichen es LLMs, fundiertere Empfehlungen für Ihr Unternehmen zu erstellen.

Diese Konvergenz der Technologien verspricht eine effizientere Verwaltung der Endgeräte, eine Senkung der Kosten und eine Verbesserung der allgemeinen IT-Sicherheit.

LLM-Anwendungsfälle

LLMs haben ihre Vielseitigkeit in zahlreichen Anwendungsfällen in verschiedenen Branchen bewiesen. Schauen wir uns einige von ihnen an.

- Textgenerierung. LLMMs bieten den meisten Nutzen für Unternehmen, die Sprachgenerierungsfähigkeiten benötigen, wie das Verfassen von E-Mails, Blogs oder anderen schriftlichen Inhalten, die leicht als Antwort auf Eingaben erstellt werden können.

- Zusammenfassung des Inhalts. Sie können lange Artikel und sehr technische Artikel in leichter verdauliche Inhalte zusammenfassen.

- KI-Unterstützung. LLMs tragen zur Chatbot-Entwicklung bei, bei der Ihre Benutzer:innen mit einer automatisierten Maschine als Teil einer Selbstbedienungslösung für die Kundenbetreuung interagieren können.

- Code-Erstellung. LLMs können IT-Entwickler bei der Erstellung von Anwendungen und der Suche nach Fehlern in Codes unterstützen.

Es gibt jedoch zahlreiche andere Anwendungsfälle, für die Sie LLMs verwenden können. Für die Endpunktverwaltung können Sie beispielsweise LLMs nutzen, um bessere Schulungsmodelle für die Cybersicherheit zu entwickeln, um Phishing-E-Mails zu identifizieren und Ransomware-Angriffe zu erkennen.

LLMs für die Endpunktverwaltung

Große Sprachmodelle können zahlreiche Vorteile für eine bessere Endpunktverwaltung bieten. In der sich ständig weiterentwickelnden IT-Landschaft müssen MSPs und IT-Unternehmen agil bleiben und verschiedene Tools nutzen, um die Arbeit zu vereinfachen und alltägliche Aufgaben zu automatisieren.

LLMs können die Benutzererfahrung durch intelligente Unterstützung und Empfehlungen zur Fehlerbehebung personalisieren. Da Endpunktumgebungen immer komplexer werden, werden LLMs zu unverzichtbaren Tools für die Verwaltung und Optimierung kritischer IT-Ressourcen.