Un modelo de lenguaje grande (LLM) es esencialmente un algoritmo de aprendizaje automático que procesa y comprende el lenguaje natural (o lo que llamaríamos «lenguaje humano»). Se trata de un tipo de modelo de base (un modelo lingüístico de uso general) entrenado sobre enormes cantidades de datos para realizar infinidad de tareas, como la generación de textos, la traducción automática, la redacción de resúmenes e incluso la codificación automática.

Los LLM utilizan metodologías de aprendizaje profundo para interpretar y analizar correctamente las complejas relaciones lingüísticas entre la semántica y la sintaxis del lenguaje para realizar acciones específicas.

Grandes modelos lingüísticos e inteligencia artificial

Los LLM representan un avance significativo en inteligencia artificial y procesamiento del lenguaje natural (PLN). Son la razón por la que podemos utilizar interfaces como ChatGPT y otros modelos generativos de IA sin necesidad de conocimientos de codificación. Piensa en la última vez utilizaste una herramienta de IA: ¿escribiste «normalmente» o como si hablaras con un humano?

En pocas palabras, los grandes modelos lingüísticos están diseñados para comprender y generar texto como lo haría un ser humano real. Además, aprenden constantemente y procesan con regularidad enormes cantidades de datos para inferir a partir del contexto, resumir textos y responder a preguntas.

En los modelos de IA generativa más avanzados, los LLM se entrenan para ayudar en la redacción de contenidos creativos o trabajos académicos. (Hay que señalar que la precisión y la calidad de estos activos producidos no están del todo a la altura, pero el mero hecho de que la IA pueda hacerlo ahora es impresionante).

Sin embargo, las oportunidades que ofrecen los LLM son asombrosas. No es descabellado imaginar innumerables mejoras en diversos campos, desde los chatbots a los asistentes virtuales, pasando por la traducción de idiomas. Incluso en el campo de las TI, que paradójicamente se resiste a la IA generativa para ayudar en la generación de código o la formación en ciberseguridad, por ejemplo, los LLM están preparados para remodelar e influir en la forma en que interactuamos con la tecnología y accedemos a la información.

De hecho, la última investigación de McKinsey descubrió que el 65% de las organizaciones utilizan regularmente IA generativa en al menos una función empresarial. Se prevé que esta cifra aumente en los próximos años.

Cómo funcionan los grandes modelos lingüísticos (LLM)

Los LLM aprovechan las técnicas de aprendizaje profundo y los datos textuales. Normalmente, estos modelos constan de varias capas de redes neuronales, cada una con parámetros que pueden mejorarse y ampliarse durante el entrenamiento.

Durante el entrenamiento, se enseña al modelo de lenguaje grande a predecir la siguiente palabra de una frase basándose en el contexto. Para ello, aplica modelos matemáticos para calcular una puntuación de probabilidad de la recurrencia de palabras que han sido tokenizadas (secuencias más pequeñas de caracteres). A continuación, los tokens se traducen en representaciones numéricas del contexto.

Esta es la primera parte. Seguidamente, los LLM se entrenan rigurosamente con cantidades ingentes de texto (literalmente, miles de millones de páginas) para ayudarles a aprender gramática, incluida la relación entre semántica y sintaxis. Esto garantiza la exactitud del contexto numérico o si la frase generada «tiene sentido».

Una vez entrenados, los grandes modelos lingüísticos pueden generar texto prediciendo la siguiente obra a partir de la entrada que reciben y aprendiendo después patrones sobre cómo se forman las frases.

Como ocurre con cualquier herramienta predictiva y generativa, se requiere un ajuste fino continuo, utilizando métodos como el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF). En la RLHF, los LLM aprenden aspectos más «humanos» de la lengua y el habla. Por ejemplo, crear un algoritmo para definir lo que es «gracioso» es difícil. Matemáticamente, es casi imposible de hacer, pero la retroalimentación humana puede calificar los chistes, lo que, a su vez, enseña al LLM el concepto de humor. De este modo, la retroalimentación humana ayuda a los LLM a aprender de forma holística a través del ensayo y error, con el modelo altamente motivado para tener éxito a través de fuertes incentivos.

El LLM y su uso en la gestión de endpoints

Puede que piense que los grandes modelos lingüísticos y la gestión de endpoints son conceptos completamente distintos. Como responsable de un MSP, puede que te preguntes por qué NinjaOne hablaría de los LLM.

Sin embargo, los LLM están cada vez más entrelazados con las empresas modernas. Su capacidad para procesar y generar texto similar al humano ofrece un potencial significativo para mejorar la experiencia de gestión de endpoints.

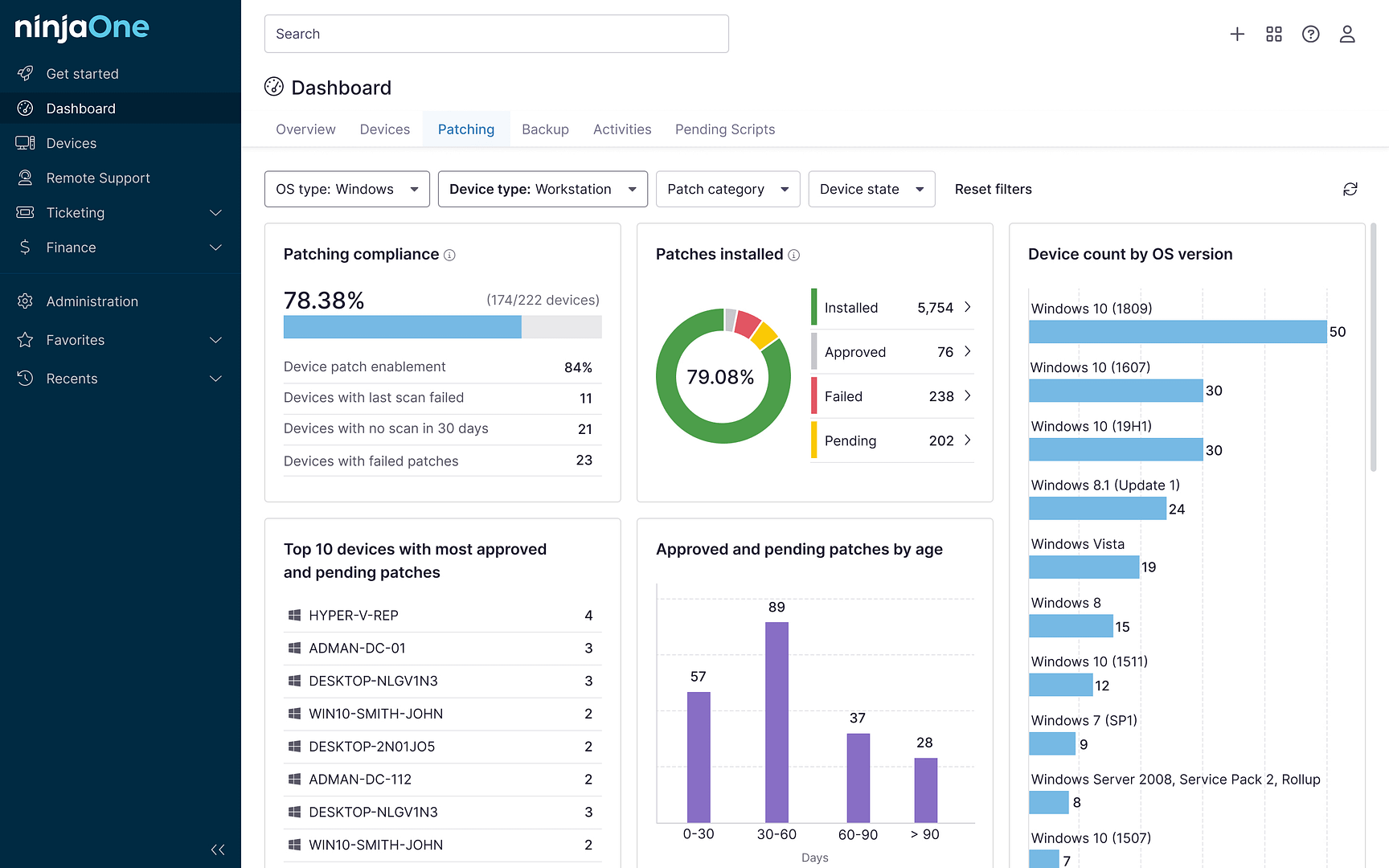

Por un lado, los LLM pueden automatizar tareas rutinarias como la gestión de parches, las actualizaciones de software y la respuesta a incidentes. Al analizar grandes cantidades de datos procedentes de endpoints, los LLM pueden identificar patrones, predecir problemas y sugerir soluciones óptimas. Esto libera a tu equipo de TI para centrarse en proyectos más estratégicos.

Por el contrario, la gestión de endpoints proporciona datos críticos para que los LLM funcionen eficazmente. Los datos completos de los endpoints, incluido el inventario de software y las especificaciones de hardware, permiten a los LLM crear recomendaciones más informadas para tu empresa.

Esta convergencia de tecnologías promete hacer más eficiente la gestión de los endpoints, reducir costes y mejorar la seguridad informática general.

Casos prácticos de LLM

Los LLM han demostrado su versatilidad en numerosos casos de uso en diversas industrias. Veamos algunos de ellos.

- Generación de texto. Los LLM ofrecen las mayores ventajas a las empresas que requieren capacidades de generación de lenguaje, como la redacción de correos electrónicos, blogs u otros contenidos escritos que puedan generarse fácilmente en respuesta a instrucciones.

- Resumen de contenidos. Puedes resumir artículos largos y muy técnicos en activos más digeribles.

- Asistencia AI. Los LLM contribuyen al desarrollo de los chatbots, donde tus usuarios pueden interactuar con una máquina automatizada como parte de una solución de autoservicio de atención al cliente.

- Generación de código. Los LLM pueden ayudar a los desarrolladores informáticos a crear aplicaciones y encontrar errores en los códigos.

Dicho esto, hay muchos otros casos en los que se pueden utilizar los LLM. Para la gestión de endpoints, por ejemplo, puedes utilizar LLM que te ayuden a desarrollar mejores modelos de formación en ciberseguridad para identificar correos electrónicos de phishing y detectar ataques de ransomware.

Grandes modelos lingüísticos para la gestión de endpoints

Los grandes modelos lingüísticos pueden ofrecer numerosas ventajas para una mejor gestión de los endpoints. En un panorama de TI en constante evolución, los MSP y las empresas de TI deben mantenerse ágiles y aprovechar diversas herramientas para simplificar el trabajo y automatizar las tareas mundanas.

Los LLM pueden personalizar la experiencia del usuario ofreciéndole asistencia inteligente y recomendaciones para la resolución de problemas. A medida que los entornos de endpoint se vuelven cada vez más complejos, los LLM están destinados a convertirse en herramientas indispensables para gestionar y optimizar los activos informáticos críticos.