La gestion efficace des journaux et l’analyse des données sont des éléments essentiels d’une infrastructure informatique performante. Elles permettent aux entreprises de gérer leurs systèmes de manière proactive, d’identifier et de traiter les problèmes potentiels et de maintenir des niveaux élevés de performance et de sécurité. Dans ce contexte, la stack ELK joue un rôle indispensable. Elle fournit un cadre unifié pour la gestion, l’analyse et la visualisation des données, ce qui simplifie et rationalise ces opérations critiques.

La stack ELK (ou simplement ELK) a considérablement évolué depuis sa création. Initialement axée sur la gestion des journaux, ses capacités se sont développées pour en faire un outil complet permettant de traiter un large éventail de tâches analytiques. Cette évolution témoigne de la demande croissante de solutions intégrées capables de gérer les complexités du Big Data. La solution ELK est un excellent exemple de cette tendance, car elle rend les analyses de données complexes plus accessibles et mieux exploitables pour les entreprises et les professionnels de l’informatique.

Qu’est-ce que la stack ELK ?

ELK est l’acronyme d’« Elasticsearch, Logstash et Kibana ». Ensemble, ces trois composants constituent une solution puissante et intégrée pour la gestion de grands volumes de données, offrant des informations en temps réel et une suite analytique complète.

- Elasticsearch en est le centre névralgique. Il s’agit d’un moteur de recherche et d’analyse très efficace, capable de traiter de grandes quantités de données avec rapidité et précision.

- Logstash est le composant de traitement des données de la stack. Il est spécialisé dans la collecte, l’enrichissement et le transport des données, les rendant ainsi prêtes pour analyse.

- Kibana est l’interface utilisateur. Elle permet aux utilisateurs de créer et de gérer des tableaux de bord et des visualisations, en transformant les données en formats facilement compréhensibles.

L’émergence d’ELK en tant qu’outil clé dans l’ère du Big Data reflète sa capacité à relever les défis complexes de la gestion et de l’analyse des données. Cette stack est devenue une solution de choix pour les entreprises qui cherchent à exploiter la puissance de leurs données.

La synergie entre Elasticsearch, Logstash et Kibana est ce qui la rend si efficace, le tout transcendant la somme de ses parties. Tous les composants se complètent, créant ainsi une puissante boîte à outils qui permet aux entreprises de transformer leurs données brutes en informations utiles. Cette synergie offre des capacités de recherche sophistiquées, un traitement efficace des données et des visualisations dynamiques, le tout au sein d’une plateforme unique et intégrée.

Principaux composants de la stack

Elasticsearch

Elasticsearch est un moteur de recherche et d’analyse distribué. Il excelle dans la gestion et l’analyse de grands volumes de données.

Ses principales caractéristiques sont les suivantes :

- Fonctionnalités avancées de recherche plein texte.

- Indexation efficace pour une recherche rapide des données.

- Fonctions puissantes d’interrogation des données.

Elasticsearch est réputé pour son évolutivité et sa fiabilité, en particulier lorsqu’il s’agit de traiter des ensembles de données volumineux. Ce logiciel est conçu pour une évolutivité horizontale, ce qui garantit que les capacités d’analyse des données d’une entreprise s’accroissent au fur et à mesure que ses besoins en données augmentent.

Logstash

Logstash joue un rôle central dans la stack ELK en tant qu’outil de collecte, de transformation et d’enrichissement des données. Il est polyvalent et peut traiter un large éventail de sources et de formats de données, y compris les journaux structurés et non structurés. L’écosystème de plugins est une caractéristique importante de Logstash, permettant aux utilisateurs d’en étendre les fonctionnalités grâce à des plugins personnalisés adaptés à des besoins spécifiques.

Kibana

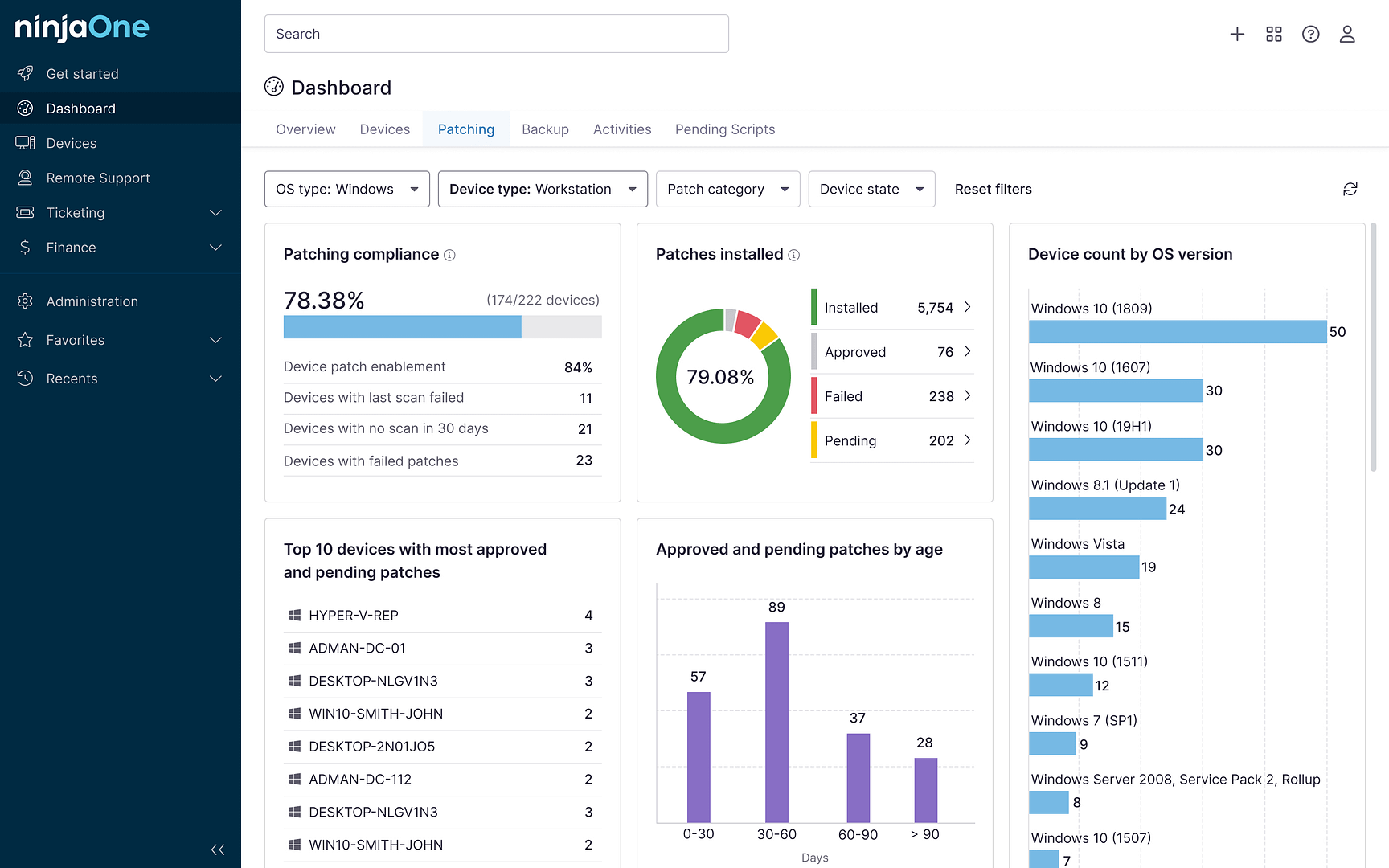

Kibana agit comme une fenêtre sur la pile ELK, fournissant une plateforme puissante pour la visualisation et l’exploration des données. Il permet aux utilisateurs de créer diverses représentations visuelles des données, telles que des tableaux de bord dynamiques en temps réel et des diagrammes et graphiques détaillés pour une analyse approfondie des données. Kibana est conçu en tenant compte de l’expérience utilisateur, offrant une interface intuitive qui permet une navigation facile et des options de personnalisation étendues.

Fonctionnalités et avantages

Gestion et analyse des journaux

ELK excelle dans la centralisation du stockage des journaux et dans la facilitation de leur analyse complète. Cette suite prend en charge le traitement des journaux en temps réel et une indexation efficace, ce qui permet d’extraire et d’analyser rapidement les données.

Visualisation des données et tableaux de bord

Kibana est un outil puissant pour créer des visualisations et des tableaux de bord interactifs. Ces visualisations permettent de tirer des informations exploitables des données de connexion et de rendre compréhensibles et utiles des ensembles de données complexes.

Suivi et analyse

ELK est très efficace pour la surveillance des performances et l’analyse des systèmes. Ses capacités vont jusqu’à la détection des anomalies, à la résolution des problèmes et à l’optimisation de l’ensemble de l’infrastructure informatique. Les applications avancées de cette stack comprennent l’analyse prédictive et l’apprentissage automatique, ce qui démontre sa polyvalence et son adaptabilité à divers cas d’utilisation.

Installation

L’un des principaux atouts d’ELK est sa nature polyvalente et en réseau, qui permet de nombreuses configurations de déploiement. Cette suite peut être installée sur une seule machine, ce qui constitue une excellente approche pour les petites configurations ou les environnements de test initiaux. Mais pour les réseaux plus performants, distribués ou à évolutivité horizontale, chaque composant de la stack peut être déployé sur des serveurs distincts. C’est cette évolutivité qui garantit que votre déploiement ELK peut gérer efficacement des charges de données croissantes et des demandes opérationnelles diverses.

Avant de nous pencher sur son installation sous Linux, vous devez impérativement tenir compte de vos besoins spécifiques en matière d’infrastructure, car le processus de configuration peut varier considérablement si vous souhaitez une installation à un seul nœud ou un environnement distribué plus complexe.

Étape 1 : Mettez votre système à jour

Mettez votre système à jour vers les derniers paquets :

sudo yum update

Étape 2 : Installez Java

Elasticsearch nécessite Java, installez donc la dernière version d’OpenJDK :

sudo yum install java-latest-openjdk

Après l’installation, vous pouvez vérifier la version de Java :

java -version

Étape 3 : Configurez votre référentiel :

Tous les composants principaux d’ELK utilisent le même référentiel de paquets, au cas où vous auriez besoin de les installer sur différents systèmes.

- Importez la clé publique GPG d’Elasticsearch dans RPM :

sudo rpm –import https://artifacts.elastic.co/GPG-KEY-elasticsearch

- Créez un nouveau fichier de référentiel pour Elasticsearch :

sudo vim /etc/yum.repos.d/elastic.repo - Ajoutez le contenu suivant :

[elastic-8.x]

name=Elastic repository for 8.x packages

baseurl=https://artifacts.elastic.co/packages/8.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-md - Mettez à jour la base de données de votre référentiel local :

sudo yum update

Étape 4 : Installez Elasticsearch, Logstash et Kibana

- Si vous installez ELK sur un seul système, exécutez la ligne suivante. Si vous devez installer ELK sur des serveurs distincts, il vous suffit d’omettre les noms des paquets qui ne sont pas nécessaires :

sudo yum install elasticsearch kibana logstash

- Activez et lancez le service Elasticsearch :

sudo systemctl enable elasticsearch

sudo systemctl start elasticsearch

- Activez et lancez le service Logstash :

sudo systemctl enable logstash

sudo systemctl start logstash

- Activez et lancez le service Kibana :

sudo systemctl enable kibana

sudo systemctl start kibana

Étape 5 : Configurez le pare-feu

- Si vous disposez d’un pare-feu, ouvrez les ports nécessaires. Par exemple, Elasticsearch utilise par défaut le port 9200, Kibana le port 5601 :

sudo firewall-cmd –add-port=5601/tcp –permanent

sudo firewall-cmd –add-port=9200/tcp –permanent

sudo firewall-cmd –reload - Pour Logstash, les ports qui doivent être ouverts dépendent des plugins d’entrée que vous utilisez et de la façon dont vous les avez configurés. Logstash n’a pas de port par défaut car il peut être configuré pour écouter les données entrantes sur n’importe quel port, en fonction des besoins de votre pipeline. Utilisez l’exemple suivant pour autoriser des ports arbitraires dans votre pare-feu :

sudo firewall-cmd –add-port=PORT_NUMBER/tcp –permanent

sudo firewall-cmd –reload

Voici quelques scénarios courants :

- Entrée Beats : Si vous utilisez Beats (comme Filebeat ou Metricbeat) pour envoyer des données à Logstash, le port par défaut du plugin d’entrée Beats est 5044.

- Entrée HTTP : Si vous utilisez le plugin d’entrée HTTP, vous pouvez le configurer pour qu’il écoute sur un port HTTP couramment utilisé, comme 8080 ou 9200.

- Entrée TCP/UDP : Pour les entrées génériques TCP ou UDP, vous pouvez configurer Logstash pour qu’il écoute sur n’importe quel port adapté à votre configuration, comme par exemple 5000.

- Entrée Syslog : Si vous utilisez Logstash pour collecter des messages syslog, les ports syslog standards comme 514 (pour UDP) sont courants.

Étape 6 : Accédez à Kibana

Après l’installation, vous pouvez accéder à Kibana depuis votre navigateur web sur http://your_server_ip:5601.

Configuration supplémentaire

- Configurez Elasticsearch, Kibana et Logstash selon vos besoins. Leurs fichiers de configuration se trouvent respectivement dans /etc/elasticsearch/elasticsearch.yml, /etc/kibana/kibana.yml et /etc/logstash/logstash.yml.

- Sécurisez votre stack ELK par l’authentification des utilisateurs et d’autres mesures de sécurité.

Remarques importantes

- Les numéros de version et les liens vers les référentiels peuvent changer, veuillez donc vous référer à la documentation officielle pour obtenir les informations les plus récentes.

- Assurez-vous toujours que votre système remplit les conditions matérielles et logicielles requises pour l’installation de ces composants.

- Il est fortement recommandé de sécuriser votre stack ELK, en particulier si elle est exposée à internet. Il s’agit notamment de mettre en place des règles d’authentification, de chiffrement et de pare-feu.

Intégration d’ELK et cas d’utilisation

Les capacités d’intégration de la suite ELK avec d’autres outils et plateformes améliorent considérablement sa fonctionnalité et son utilité. Couvrant diverses industries, ses cas d’utilisation sont variés. En voici quelques examples :

- Mécanismes avancés de sécurité et de détection des menaces.

- Informatique décisionnelle et analyse de données approfondies.

- Contrôle complet des performances des applications.

Le domaine de l’analyse des données continue d’évoluer, tout comme la stack ELK. Elle s’adapte aux nouvelles tendances et aux nouveaux développements, maintenant sa pertinence et son efficacité dans le paysage en constante évolution de l’infrastructure informatique.

Elasticsearch, Logstash et Kibana apportent chacun des fonctionnalités uniques et puissantes à la solution ELK

Cette dernière est indispensable pour la gestion des journaux, l’analyse et la surveillance des systèmes. Avec des applications allant de la simple agrégation de journaux à l’analyse de données complexes et à la modélisation prédictive, son importance dans le domaine de l’informatique ne devrait pas être sous-estimée.

Tout le monde peut se plonger dans ELK. De nombreuses ressources sont disponibles pour celles et ceux qui souhaitent approfondir leurs connaissances et leurs compétences, notamment des guides complets, des forums actifs et des réseaux professionnels. Cette stack ne représente pas seulement un ensemble d’outils, mais une passerelle permettant de libérer le vaste potentiel des données pour faire progresser les entreprises et l’innovation technologique.